Press "Enter" to skip to content

写在前面

其他常见神经网络

- RBF(Radial Basis Function, 径向基函数)网络, 是一种但隐层前馈神经网络, 它使用径向基函数作为隐层神经元激活函数, 而输出层则是对隐层神经元输出的线性组合. 假定输入为

维向量

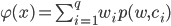

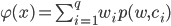

维向量  , 输出为实值, 则RBF网络可表示为:

, 输出为实值, 则RBF网络可表示为:

其中,  为隐层神经元个数,

为隐层神经元个数,  和

和  分别是第

分别是第  个隐层神经元所对应的中心和权重,

个隐层神经元所对应的中心和权重,  是径向基函数, 这事某种沿径向堆成的标量函数, 通常定义为样本

是径向基函数, 这事某种沿径向堆成的标量函数, 通常定义为样本  到数据中心

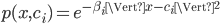

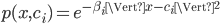

到数据中心  之间欧氏距离的单调函数. 常用的高斯径向基函数形如:

之间欧氏距离的单调函数. 常用的高斯径向基函数形如:

通常采用两步过程来训练RBF网络:

1.第一步, 确定神经元中心  , 常用的方式包括随机采样, 聚类等.

, 常用的方式包括随机采样, 聚类等.

2.第二步, 利用BP算法等来确定参数  和

和  .

.

- ART(Adaptive Resonance Theory, 自适应谐振理论)网络, 是竞争性学习(Competitive Learning)的重要代表. 该网络由比较层, 识别层, 识别阈值和重置模块构成. 其中比较层负责接收输入样本, 并将其传递给识别层神经元. 识别层每个神经元对应一个模式类, 神经元数目可在训练过程中动态增长以增加新的模式类.

- SOM(Self-Oranizing Map, 自组织映射)网络, 是一种竞争型的无监督神经网络, 它能将高纬输入数据映射到低维空间(通常为二维), 同时保持输入数据在高维空间的拓扑结构, 即将高维空间中相似的样本点映射到网络输出层中的邻近神经元. SOM的训练过程很简单: 在接收到一个训练样本后, 每个输出层神经元会计算该样本与自身携带的权向量之间的距离, 距离最近的神经元称为竞争获胜者, 称为最佳匹配单元(Best Maching Unit). 然后最佳匹配单元及其邻近的神经元的权向量将被调整, 以是的这些权向量与当前输入样本的距离缩小, 这个过程不断迭代, 直至收敛.

- 级联相关(Cascade-Correlation)网络, 是结构自适应网络的重要代表. 级联相关网络有两个主要成分: '级联'和'相关'. 级联是指简历层次连接的层次结构. 在开始训练时, 网络只有输入层和输出层, 处于最小拓扑结构; 随着训练的进行, 新的隐层神经元逐渐加入, 从而创建起层级结构. 当新的隐层神经元加入时, 其输入端连接权值是冻结固定的. 相关是指通过最大化新神经元的输出与网络误差之间的相关性(Correlation)来训练相关的参数. 与一般的前馈神经网络相比, 级联相关网络无序设置网络层数, 隐层神经元数, 且训练速度较快, 但在数据较小时易陷入过拟合.

- Elman网络, 是最常用的递归神经网络(Recurrent Neural Networks)之一, 它的结构与多层前馈网络很相似, 但隐层神经元的输出被反馈回来, 与下一时刻输入层神经元提供的信号一起, 作为隐层神经元在下一时刻的输入. 因层神经元通常采用Sigmoid激活函数, 而网络的训练则常通过推广的BP算法进行.

- Boltzmann机, 是一种'基于能量的模型'(Energy-Based Model), 其神经元分为两层: 显层与隐层. 显层用于表示数据的输入与输出, 隐层则被理解为数据的内在表达. Boltzmann机中的神经元都是布尔型的, 即只能取0, 1两种状态, 状态1表示激活, 状态0表示抑制.

写在后面

- 在此文中, 我们介绍了一些常用的其他神经网络, 可能有些连名字都没听说过的网络模型, 没关系, 我们先有个概念, 需要的时候再去详细了解就好了.

- 明天, 我们将会继续学习神经网络-深度学习.

Related

维向量

维向量  , 输出为实值, 则RBF网络可表示为:

, 输出为实值, 则RBF网络可表示为:

为隐层神经元个数,

为隐层神经元个数,  和

和  分别是第

分别是第  个隐层神经元所对应的中心和权重,

个隐层神经元所对应的中心和权重,  是径向基函数, 这事某种沿径向堆成的标量函数, 通常定义为样本

是径向基函数, 这事某种沿径向堆成的标量函数, 通常定义为样本  到数据中心

到数据中心  之间欧氏距离的单调函数. 常用的高斯径向基函数形如:

之间欧氏距离的单调函数. 常用的高斯径向基函数形如:

, 常用的方式包括随机采样, 聚类等.

, 常用的方式包括随机采样, 聚类等. 和

和  .

.

Be First to Comment